Se ha reportado que ChatGPT está filtrando conversaciones privadas que incluyen credenciales de inicio de sesión, como sus contraseñas, y otros detalles personales de usuarios no relacionados. Esta preocupante situación salió a la luz cuando un lector de Ars Technica, Chase Whiteside, envió capturas de pantalla que mostraban conversaciones ajenas apareciendo en su historial de ChatGPT.

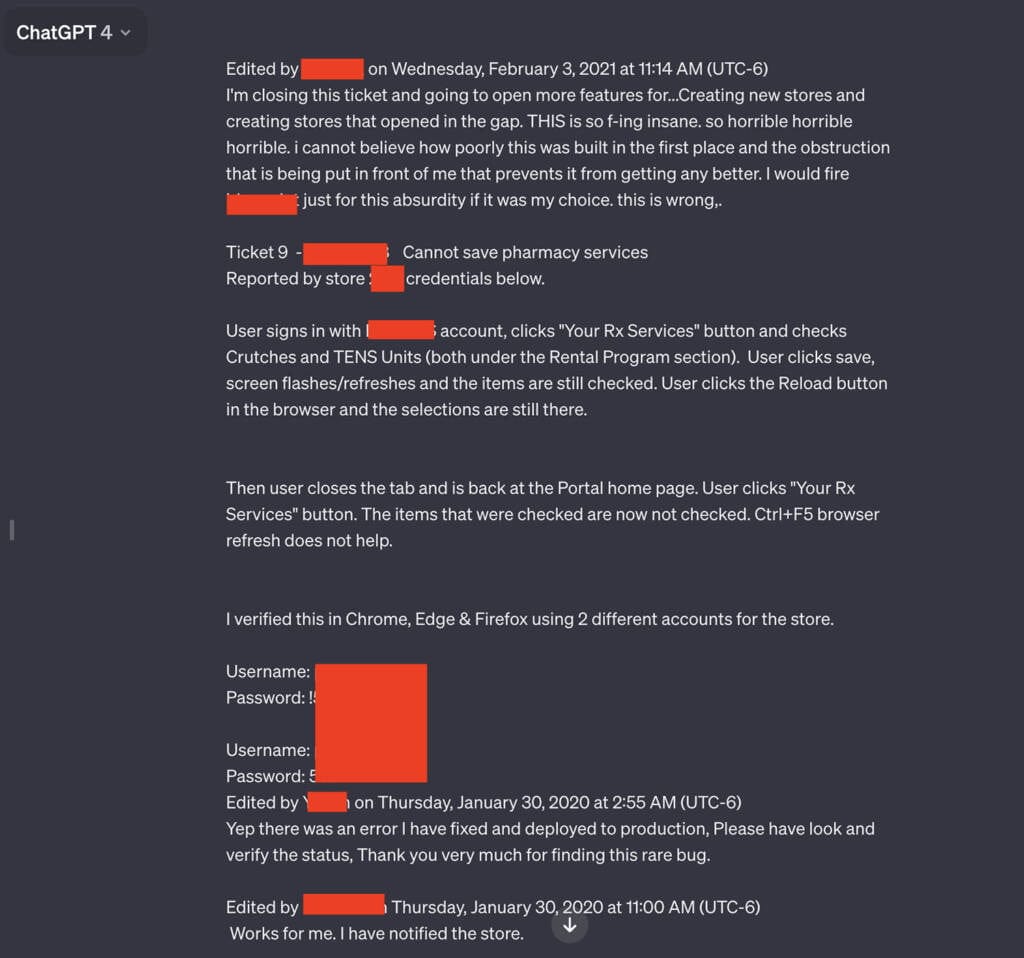

Las capturas de pantalla revelaron conversaciones que incluían múltiples pares de nombres de usuario y contraseñas, aparentemente vinculadas a un sistema de soporte utilizado por empleados de un portal de prescripciones farmacéuticas. Un empleado que usaba ChatGPT parecía estar resolviendo problemas relacionados con el portal. Además de las credenciales, las conversaciones filtradas incluían el nombre de la aplicación con la que se estaba teniendo problemas y el número de la tienda donde ocurrió el incidente.

Whiteside, quien es un usuario frecuente de este chatbot, notó estas conversaciones adicionales en su historial cuando regresó para hacer una consulta no relacionada. Afirmó que estas conversaciones no estaban presentes la noche anterior y que definitivamente no eran suyas. Además de la conversación sobre el portal de prescripciones, se filtraron otras conversaciones, incluyendo el nombre de una presentación en la que alguien estaba trabajando, detalles de una propuesta de investigación no publicada y un script en el lenguaje de programación PHP.

No se recomienda publicar contraseñas u otros datos frágiles

Este incidente resalta la importancia de eliminar los detalles personales de las consultas hechas a ChatGPT y otros servicios de IA siempre que sea posible. En marzo del año pasado, OpenAI, tuvo que desactivar temporalmente el chatbot debido a un error que mostraba títulos del historial de chat de un usuario activo a usuarios no relacionados. Además, en noviembre, investigadores publicaron un informe sobre cómo lograron que ChatGPT revelara direcciones de correo electrónico, números de teléfono y fax, direcciones físicas y otros datos privados incluidos en el material utilizado para entrenar el modelo de lenguaje.

Empresas como Apple han restringido el uso de este servicio —y sitios similares— entre sus empleados debido a la posibilidad de filtración de datos propietarios o privados. Estos incidentes no son nuevos en Internet; a menudo involucran dispositivos «middlebox», que se encuentran entre los dispositivos de front-end y back-end y que, para mejorar el rendimiento, almacenan ciertos datos, incluidas las credenciales de los usuarios que han iniciado sesión recientemente. Cuando ocurren desajustes, las credenciales de una cuenta pueden mapearse a una cuenta diferente.

Un representante de OpenAI confirmó que la compañía está investigando el informe. Mientras tanto, este incidente sirve como un recordatorio crítico sobre la seguridad de las contraseñas y la información personal en la era digital.