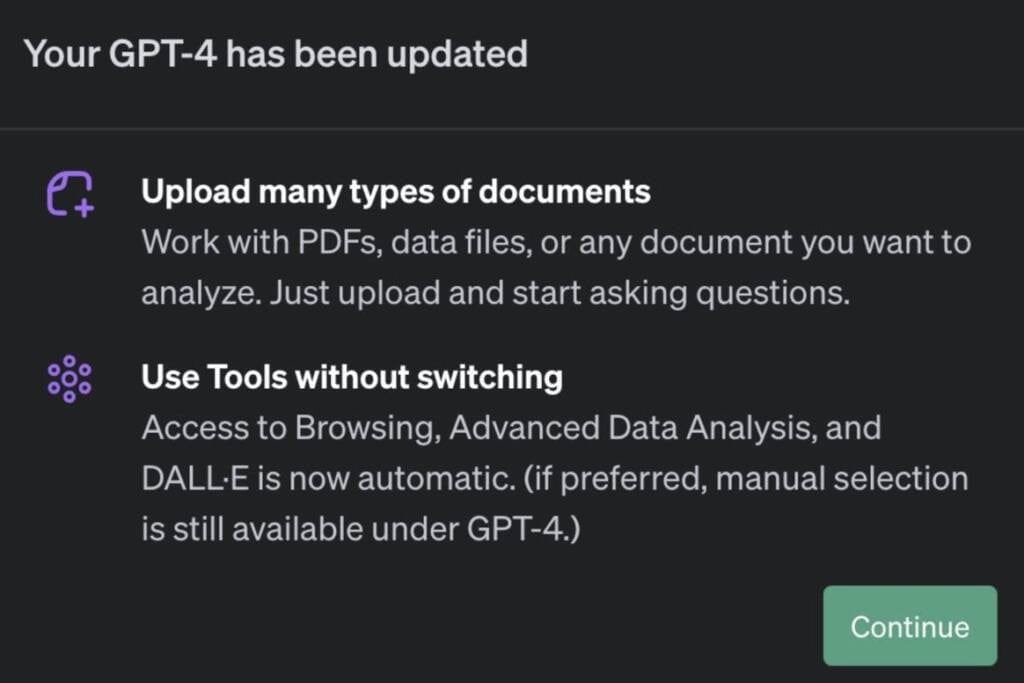

OpenAI ha lanzado nuevas características en beta para los miembros de ChatGPT Plus. Los suscriptores han informado que la actualización incluye la capacidad de cargar archivos y trabajar con ellos, así como soporte multimodal. Esto significa que los usuarios no tendrán que seleccionar modos como «Browse with Bing» desde el menú desplegable de GPT-4; el sistema adivinará lo que quieren basándose en el contexto.

Las nuevas características introducidas ofrecen una variedad de funciones de oficina que anteriormente estaban disponibles en el plan ChatGPT Enterprise. Estas funciones ahora están disponibles para la suscripción individual del chatbot. Aunque no todos los usuarios han recibido la actualización multimodal, se ha confirmado que la función de Análisis de Datos Avanzado funciona según lo esperado.

Una vez que se carga un archivo en ChatGPT, el sistema tarda unos momentos en procesar el archivo antes de estar listo para trabajar con él. Luego, el chatbot puede realizar tareas como resumir datos, responder preguntas o generar visualizaciones de datos basadas en indicaciones.

Interacción con diversos tipos de archivos

No sólo se limita a archivos de texto. En Threads, un usuario compartió capturas de pantalla de una conversación en la que cargó una imagen de un carpincho y pidió a ChatGPT que, a través de DALL-E 3, creara una imagen al estilo Pixar basada en ella. Luego, iteraron en el concepto de la primera imagen cargando otra imagen, esta vez de un monopatín ondulado, y pidiéndole que insertara esa imagen. Por alguna razón, también le añadió un sombrero.

Esta capacidad de interactuar con diferentes tipos de archivos y generar contenido basado en ellos es un testimonio de las capacidades avanzadas de ChatGPT y las posibilidades que ofrece para los usuarios. Ya sea que se trate de analizar datos, generar visualizaciones o interactuar con imágenes y otros medios, las nuevas características en beta de ChatGPT Plus están ampliando las fronteras de lo que es posible con la inteligencia artificial.