OpenAI anunció a «GPT-4o mini», un modelo más pequeño y asequible y que reemplazará a GPT-3.5 en ChatGPT —a partir de hoy— para usuarios gratuitos y suscriptores de ChatGPT Plus y Team, con acceso para usuarios empresariales la próxima semana. GPT-4o mini es más económico para los desarrolladores, con un costo de 15 centavos por millón de tokens de entrada y 60 centavos por millón de tokens de salida, lo que supone una reducción del 60% en comparación con GPT-3.5 turbo.

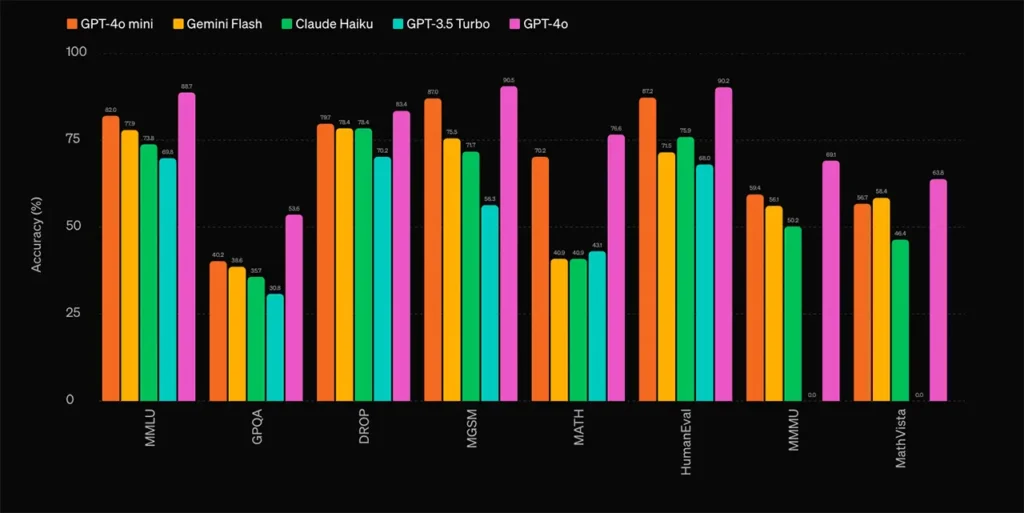

Según informó la compañía, GPT-4o mini ha obtenido una puntuación del 82% en el benchmark MMLU (Medición de Entendimiento Lingüístico Multitarea Masivo), superando a GPT-3.5 turbo que obtuvo un 70%. Este nuevo modelo es multimodal, lo que significa que puede interpretar y generar texto e imágenes, y en el futuro podrá procesar audio y video. Además, utiliza una técnica llamada jerarquía de instrucciones, que mejora su capacidad para resistir ataques de inyección de prompts y «jailbreaks».

Ventajas de GPT-4o mini

El nuevo modelo permite a los desarrolladores crear aplicaciones de inteligencia artificial más flexibles y asequibles. Este es especialmente útil para tareas que requieren múltiples llamadas, manejo de grandes volúmenes de contexto, o interacciones rápidas en tiempo real, como chatbots de soporte al cliente. Gracias a su ventana de contexto de 128k tokens y soporte para hasta 16k tokens de salida por solicitud, GPT-4o mini es capaz de manejar tareas complejas y de gran volumen de datos con mayor eficiencia.

GPT-4o mini ha demostrado un rendimiento superior en benchmarks académicos y de razonamiento multimodal. En tareas de razonamiento textual y visual, obtuvo una puntuación de 820 en el benchmark MMLU, superando a otros modelos pequeños como Gemini Flash y Claude Haiku. En matemáticas y tareas de codificación, también mostró una ventaja, con puntuaciones de 870 en MGSM y 872 en HumanEval.

Respecto a la seguridad, OpenAI explica que este modelo incluye las mismas medidas de seguridad que su ‘hermano mayor’ GPT-4o. Estas medidas fueron evaluadas por más de 70 expertos externos en campos como la psicología social y la desinformación. El modelo está diseñado para filtrar contenido inapropiado durante el preentrenamiento y alinear su comportamiento con las políticas de la empresa mediante técnicas como el aprendizaje por refuerzo con retroalimentación humana (RLHF).