La plataforma de videos de Google está trabajando en nuevas herramientas para proteger a creadores, artistas y figuras públicas de la utilización no autorizada de sus voces y rostros mediante deepfakes. Estas herramientas permitirán detectar un contenido generado con inteligencia artificial que simule la apariencia o la voz de una persona sin su consentimiento.

Una de las tecnologías desarrolladas está enfocada en la detección de voces sintéticas. Este sistema se integrará dentro de Content ID, la plataforma de gestión de derechos de autor de YouTube. La herramienta está diseñada para que los artistas musicales puedan identificar y gestionar contenido que utilice versiones generadas por inteligencia artificial de sus voces, lo que representa una importante medida para evitar la proliferación de canciones que imiten a cantantes conocidos sin su autorización.

Esta herramienta será de gran utilidad para las grandes discográficas y artistas famosos, como Taylor Swift o Billie Eilish, quienes podrán encontrar y eliminar rápidamente videos que usen versiones falsas de sus voces. Algo que la compañía ya venía anunciando desde el año pasado que permitirá, sólo que ahora será más automatizado.

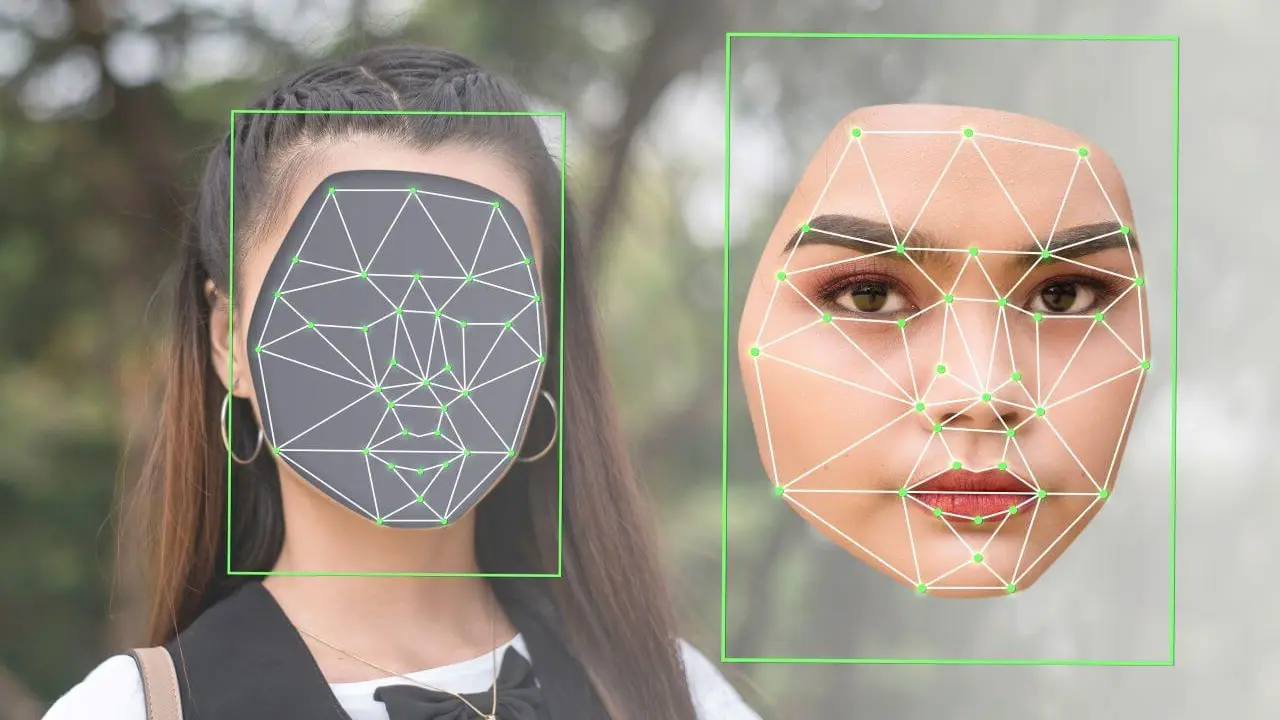

Deepfakes de rostros

Además de la tecnología para las voces, YouTube está desarrollando una herramienta de reconocimiento facial para identificar videos que muestren deepfakes de rostros. Esta permitirá a actores, atletas, músicos e influencers localizar videos en los que se utilicen versiones generadas por inteligencia artificial de sus rostros. Sin embargo, aún no se ha especificado si la plataforma implementará este sistema de manera proactiva para personas que no sean figuras públicas.

A través de su política de privacidad actualizada, YouTube permite a cualquier persona solicitar la eliminación de contenido de deepfakes que utilice su imagen sin consentimiento. Aunque las pautas comunitarias de YouTube ya prohíben contenido engañoso, el proceso para la eliminación de estos videos requiere que los usuarios los reporten manualmente.