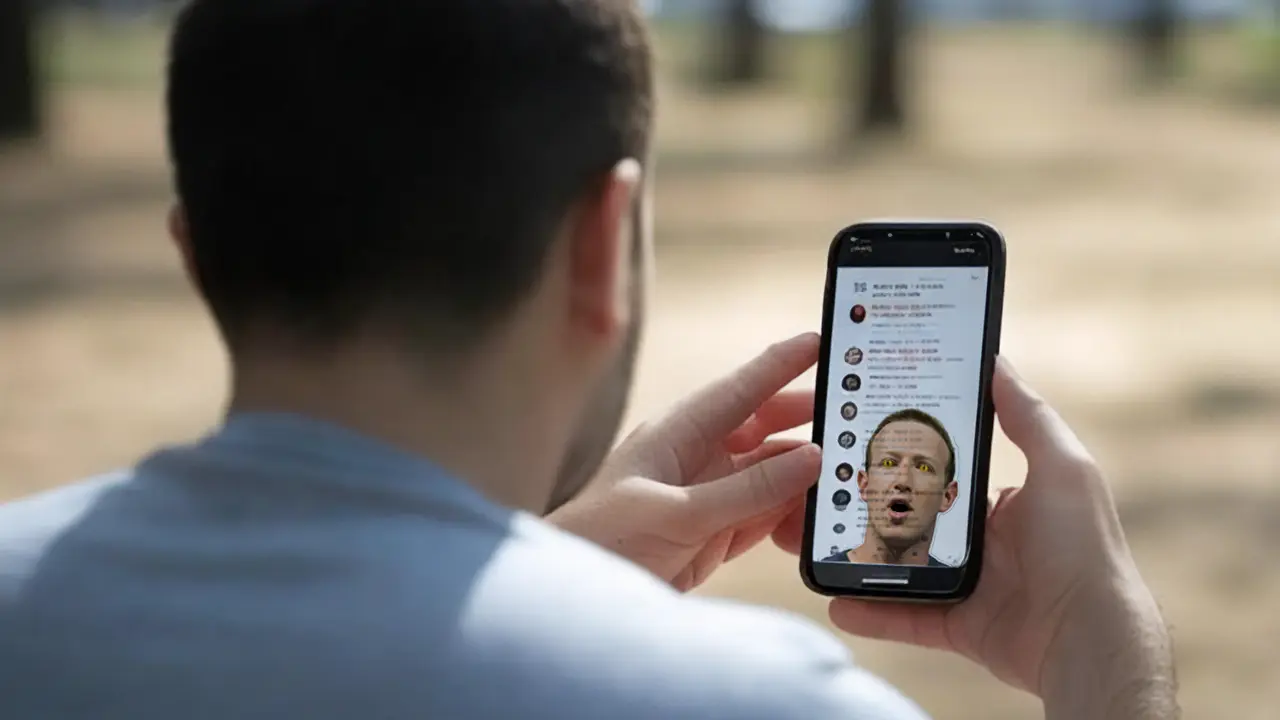

Como ya les habíamos contado, Meta —a través del propio Mark Zuckerberg— anunció la eliminación de su programa de verificación de hechos, reemplazándolo con un modelo de «Community Notes» basado en aportes de los usuarios. Esta decisión coincide con cambios en las políticas de moderación de contenido en todas sus plataformas y los expertos han expresado preocupaciones sobre los peligros asociados, como el aumento de desinformación, discursos de odio y la afectación de derechos de minorías.

Con el nuevo enfoque, Meta dejará de trabajar con organizaciones independientes que verificaban la información publicada en sus plataformas. Estas entidades etiquetaban contenido falso y reducían su alcance. Ahora, el sistema de Community Notes permitirá a los usuarios añadir contexto a publicaciones engañosas. Sin embargo, estudios sugieren que este modelo es más lento y menos efectivo en abordar temas sensibles en comparación con los verificadores profesionales.

Mark Zuckerberg justificó este cambio argumentando que los verificadores externos eran «políticamente sesgados» y dañaban la confianza de los usuarios. Además, Meta relajará las restricciones sobre temas controversiales como inmigración y género, permitiendo que más contenido permanezca visible. Este cambio busca alinear las políticas de la empresa con un enfoque más permisivo hacia la «libertad de expresión». No obstante, críticos señalan que esto podría amplificar teorías conspirativas y fomentar el odio.

Consecuencias por eliminar la verificación de hechos

La decisión de Meta llega en un contexto político tenso en Estados Unidos, con la inminente toma de posesión de Donald Trump como presidente. Algunos observadores consideran que este movimiento es un intento de Zuckerberg de evitar represalias políticas y asegurar un clima regulatorio favorable. A pesar de estas posibles motivaciones estratégicas, las implicaciones para los usuarios y la democracia son preocupantes.

Expertos en desinformación alertan sobre el posible incremento de contenido falso que podría viralizarse antes de ser revisado por Community Notes. Además, se teme que grupos organizados manipulen el sistema para difundir información perjudicial. Investigaciones anteriores sobre plataformas con sistemas similares, como X (antes Twitter), han demostrado que este modelo puede fallar en reducir la propagación de discursos de odio y manipulación extranjera.

La eliminación de la verificación de hechos también podría afectar gravemente a las organizaciones dedicadas a esta labor, ya que Meta era una fuente significativa de financiamiento para estos grupos. A nivel publicitario, algunos analistas predicen riesgos de deserción de anunciantes, similar a lo que ocurrió en X tras sus cambios en moderación.

La combinación de un modelo de moderación menos restrictivo y la eliminación de los verificadores de hechos plantea serios desafíos para garantizar un entorno informativo confiable en las plataformas de Meta. A medida que se implementan estas políticas, queda por ver si los usuarios experimentarán un aumento de contenido perjudicial y cómo esto impactará en la percepción pública de las redes sociales como espacios seguros y confiables.